آشنایی با Googlebot: قسمت دوم

با قسمت دوم از مبحث آشنایی با Googlebot در خدمت شما هستیم. در قسمت قبل به مبحث زیر رسیدیم:

اطمینان از شناخته شدن سایت شما توسط گوگل

حالا چه کار کنیم که وب سایت ما حتما توسط گوگل شناخته شود؟ باید سه مسئله ی اصلی را رعایت کنید:

- آیا Googlebot می تواند وب سایت من و صفحات اش را ببیند؟

- آیا Googlebot می تواند به تمام محتوا و لینک های وب سایت من دسترسی داشته باشد؟

- آیا Googlebot می تواند به منابع وب سایت من دسترسی داشته باشد؟

در این جلسه قصد داریم به این سوالات پاسخ دهیم.

سوال 1: آیا Googlebot می تواند وب سایت من و صفحاتش را ببیند؟

برای اینکه بدانید گوگل چه چیزهایی از سایت شما را می بیند متن زیر را در گوگل سرچ کنید:

site:yourwebsite.com

به جای عبارت yourwebsite.com باید آدرس سایت خودتان را قرار دهید. همچنین نباید هیچ کاراکتری (حتی اسپیس) بین نام سایت شما و علامت دو نقطه (:) وجود داشته باشد.

زمانی که از دستور :site استفاده می کنید گوگل لیست صفحاتی را که از سایت شما ایندکس کرده است، به شما تحویل خواهد داد. به طور مثال روی این لینک کلیک کنید تا لیست صفحات ایندکس شده ی روکسو را ببینید.

اگر تعداد صفحاتی که انتظار دارید دیده نمی شود و یا اصلا هیچ صفحه ای نشان داده نمی شود بهتر است چک کنید و ببینید آیا Googlebot را در فایل robots.txt خود مسدود کرده اید یا خیر (در رابطه با این فایل در ادامه صحبت خواهیم کرد).

سوال 2: آیا Googlebot می تواند به تمام محتوا و لینک های وب سایت من دسترسی داشته باشد؟

در قدم بعدی باید مطمئن شویم که Google محتوای سایت شما را به درستی می بیند. به عبارت دیگر اینکه گوگل می تواند صفحات وب شما را ببیند لزوما بدین معنی نیست که کاملا از محتوای این صفحات با خبر است. Googlebot وب سایت ها و صفحات را به شکل انسان ها نمی بیند. به طور مثال در تصویر بالا یک صفحه ی وب را داریم که درون خود دارای یک تصویر است. شما به عنوان یک انسان، این تصویر را می بینید اما Googlebot تنها کدی را می بیند که این تصویر را صدا زده است.

Googlebot به صفحه ی HTML ما دسترسی دارد اما ممکن است به دلایل مختلف نتواند به تصویری که در این صفحه است دسترسی داشته باشد. در چنین حالتی این تصویر از طرف گوگل ایندکس نمی شود و بنابراین درک گوگل از صفحه ی شما ناقص است. باید قبل از ادامه ی توضیحات مطلبی را توضیح بدهم...

Googlebot چطور صفحات وب را می بیند؟

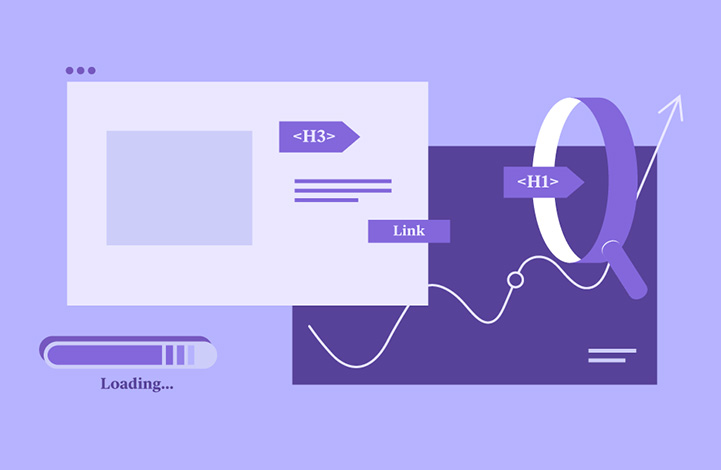

Googlebot صفحات وب را به طور یکجا و واحد نمی بیند بلکه تنها اجزای مختلف صفحه را به صورت جداگانه می بیند. حال اگر هر کدام از این اجزا در دسترس Googlebot نباشند، Googlebot نیز آن ها را به Google Index نمی فرستد. باید بدانید برای اینکه گوگل بتواند صفحات شما را به طور صحیح و بهینه ایندکس کند و حق شما ضایع نشود باید به تمامی منابع صفحه دسترسی داشته باشد. حتما با خودتان می گویید در چه مواقعی Googlebot به برخی از عناصر صفحه دسترسی ندارد؟ نمونه های زیر تنها چند مثال هستند:

- منابع مختلف در فایل robots.txt مسدود شده باشند.

- لینک صفحات قابل خواندن نبوده و یا اشتباه باشند.

- تکیه ی افراطی بر تکنولوژی هایی مانند Flash که web crawler ها با آن مشکل داشته باشند.

- HTML نویسی (و به طور کل کدنویسی) بد و غیر استاندارد؛ برای تست سایت خود از اعتبارسنج HTML استفاده کنید.

- لینک های شدیدا پویا (dynamic) و پیچیده

شما می توانید به صفحه ی Google search console رفته و از "fetch and render" استفاده کنید؛ این صفحه به صورت زنده به شما نشان می دهد که Google چه چیزی از یک صفحه را می بیند (برای این کار باید وارد حساب کاربری گوگل خود بشوید).

سوال 3: آیا Googlebot می تواند به منابع وب سایت من دسترسی داشته باشد؟

مسدود بودن فایل های CSS و جاوا اسکریپت شما در فایل robots.txt می تواند منجر به سوء تفاهم های بزرگی در مورد وب سایت شما بشود که بسیار بدتر از درک نشدن یک تصویر توسط گوگل است. یک مثال خوب در این زمینه سایت های واکنش گرا (responsive) هستند که توسط فایل های CSS و جاوا اسکریپت نوع نمایش صفحه را بر اساس دستگاه کاربر (موبایل، لپتاپ، تبلت و ...) تعیین می کنند. اگر در چنین سایت هایی فایل های CSS و جاوا اسکریپت مسدود شده باشند، گوگل نمی تواند بفهمد که چنین وب سایتی قابلیت واکنش گرا بودن دارد و امتیاز این قسمت را از دست خواهید داد (چرا که گوگل طراحی responsive را یک امتیاز مثبت می داند).

در چنین حالتی گوگل صفحه ی شما را میبیند و ممکن است حتی آن را درک هم بکند اما آن قدر این وب سایت را نمی شناسد که بخواهد آن را در موقعیت های مختلف (به غیر از حالت HTML ساده) ایندکس و رتبه بندی کند.

آیا می توان Googlebot را کنترل کرد؟

بله می توانید به راحتی چنین کاری را انجام دهید. Googlebot دستوراتی را که در فایل robots.txt باشد خوانده و از آن ها پیروی می کند. راه های کنترل Googlebot از این قرار هستند:

- استفاده از فایل robots.txt

- اضافه کردن دستورات ربات به قسمت metadata ی سایت خود

- اضافه کردن دستورات ربات به header های سایت خود

- استفاده از sitemap ها

- استفاده از Google search console

رایج ترین و شاید راحت ترین روش کنترل این ربات استفاده از فایل robots.txt است.

فایل robots.txt چیست؟

فایل robots.txt در واقع به ربات های crawler موتورهای جست و جو می گوید چطور با وب سایت شما تعامل داشته باشند. به عبارت ساده تر این فایل به Googlebot میگوید زمانی که به صفحه ی شما رسید چه کار کند؛ به طور مثال می توانید فایل ها و پوشه هایی را که دوست ندارید ایندکس شوند در این صفحه قرار دهید. مبحث این فایل طولانی است و در مقاله ی ما نمی گنجد، برای آشنایی کامل با این فایل مقاله های زیر را مطالعه کنید:

- فایل Robots.txt چیست و چگونه آن را بهینه سازی کنیم؟

- صفر تا صد سئو | درس نهم: بررسی ابزار گوگل سرچ کنسول (قسمت دوم)

برای آشنایی بیشتر با این مباحث پیشنهاد می کنم دیگر مقالات روکسو در زمینه ی سئو را نیز مطالعه کنید.

همچنین مقالات بسیار عالی زیر را از خود گوگل مطالعه کنید (به زبان انگلیسی):

- فایل robots.txt

- نگاهی فنی به نحوه ی تعامل گوگل با فایل robots.txt

- تگ های meta و header ها در تعامل با ربات ها

در مورد دو مقاله ی آخر باید گفت که متاسفانه IP ایران تحریم شده است و شما باید از ابزار دور زدن تحریم استفاده کنید.

همچنین در مورد موارد دیگری که در این مقاله ذکر شد (مانند sitemap ها و Google search console) می توانید از سری آموزشی صفر تا صد سئو در روکسو استفاده کنید؛ درس های هفتم، هشتم و نهم مربوط به بحث ما هستند اما دیگر مقالات نیز کمک خوبی به شما می کنند.

چند نوع Googlebot وجود دارد؟

برخلاف تصور تازه کاران، ما تنها یک Googlebot نداریم بلکه 9 Googlebot یا Google webcrawler مختلف وجود دارد:

- (Googlebot (Google Web search

- Google Smartphone

- (Google Mobile (Feature phone

- Googlebot Images

- Googlebot Video

- Googlebot News

- Google Adsense

- Google Mobile Adsense

- Google Adsbot (کنترل کیفی landing page)

اگر دوست دارید در مورد تک تک این ربات ها اطلاعاتی داشته باشید به صفحه ی Google crawlers مراجعه کنید. در این صفحه اطلاعات کاملی از این ربات ها وجود دارد.

اگر وب سایت من چند زبانه باشد...؟

در این مورد نیازی به نگرانی نیست. Googlebot این مشکل را با دو روش حل کرده است:

- Geo-distributed crawling (انجام crawl بر اساس موقعیت جغرافیایی): Googlebot از IP های مختلفی استفاده می کند تا از کشورهای مختلفی به وب سایت شما سر زده باشد و اگر سیستم وب سایت شما توزیع محتوا بر اساس منطقه ی جغرافیایی است، این مورد مشکل شما را حل خواهد کرد.

- Language-dependent crawling (انجام crawl بر اساس زبان): در این حالت Googlebot در HTTP header ها از دستور Accept-Language استفاده می کند (در صورت عدم آشنایی با header ها، در اینترنت جست و جو کنید).

این دو روش اصلی گوگل برای حل مشکل وب سایت های چند زبانه اند اما گوگل هنوز هم استفاده از hreflang را پیشنهاد می کند و آن را بهترین راه می داند. اگر وب سایت شما چند زبانه است قبل از هر کاری سری به مقاله ی locale-aware Googlebot crawling بزنید و اطلاعات کافی در این مورد را کسب کنید.

آشنایی با Googlebot از موارد بسیار مهم برای وبمستران است و ما در این مقاله سعی کردیم مسائل اصلی مربوط به این بحث را پوشش دهیم. امیدوارم از این مقاله لذت برده باشید.

در این قسمت، به پرسشهای تخصصی شما دربارهی محتوای مقاله پاسخ داده نمیشود. سوالات خود را اینجا بپرسید.